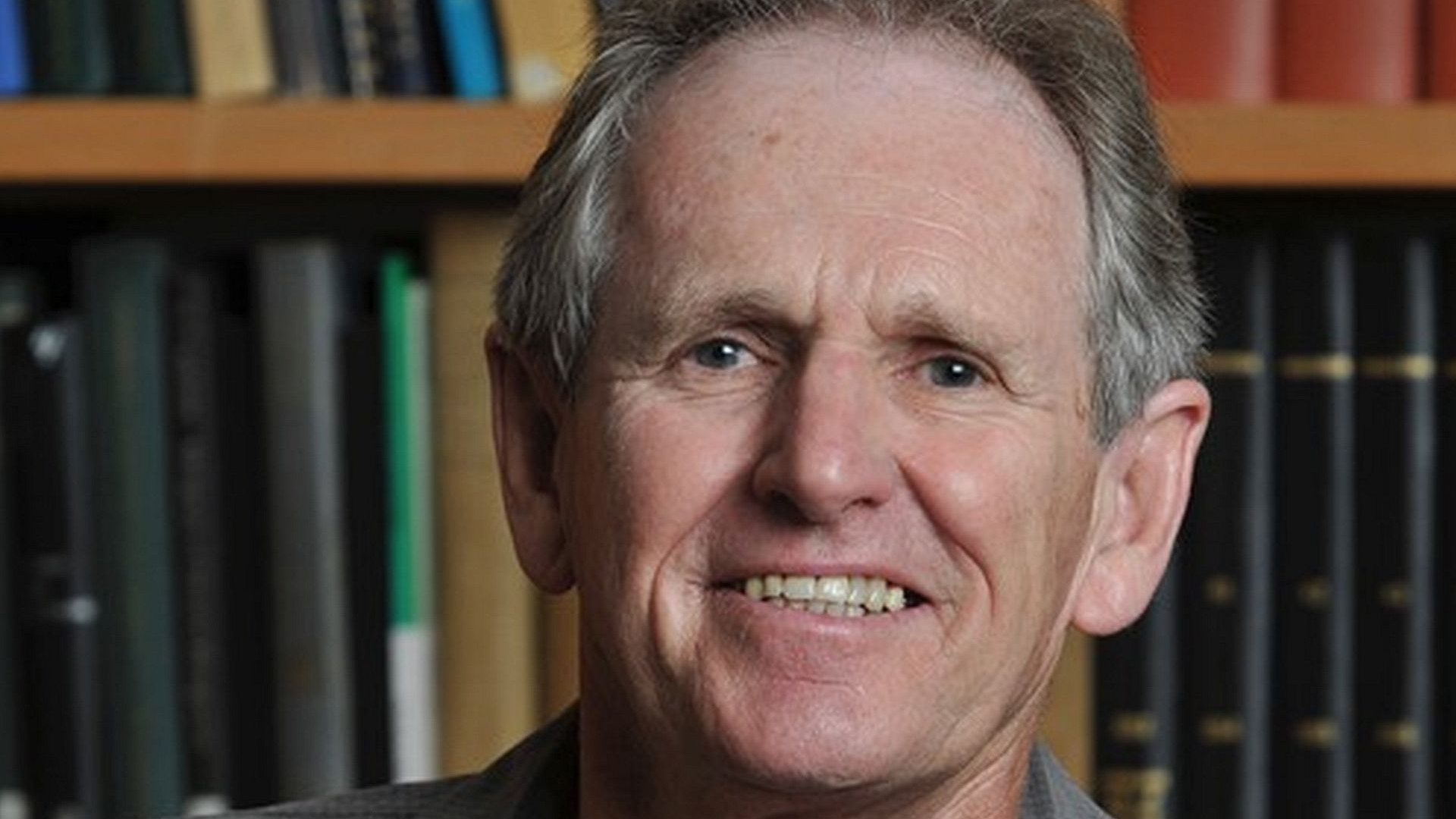

©Trevor Hastie

©Trevor Hastie

Forschungskolloquium Wirtschaftsinformatik

Forschungskolloquium Wirtschaftsinformatik

21. Okt.

Im Rahmen des Forschungskolloquiums Wirtschaftsinformatik und Data Science referiert am 21. Oktober 2021, 16:15 Uhr, Prof. Trevor Hastie, Department of Statistics and Department of Biomedical Data Science, Stanford University über Neuronale.

Neuronale Netze wurden in den späten 1980er Jahren bekannt. Es gab viel Aufregung und einen gewissen Hype um diesen Ansatz. Es folgte eine Synthesephase, in der die Eigenschaften neuronaler Netze von Machine Learners, Mathematikern und Statistikern analysiert wurden; die Algorithmen wurden verbessert, und die Methodik stabilisierte sich. Dann kamen SVMs, Boosting und Random Forests auf, und neuronale Netze fielen etwas in Ungnade. Das lag zum Teil daran, dass neuronale Netze viel Bastelei erforderten, während die neuen Methoden automatischer waren. Außerdem schnitten die neuen Methoden bei vielen Problemen besser ab als schlecht trainierte neuronale Netze. Dies war der Status quo für das erste Jahrzehnt des neuen Jahrtausends. Währenddessen trieb jedoch eine Kerngruppe von Enthusiasten neuronaler Netze ihre Technologie auf immer größeren Computerarchitekturen und Datensätzen voran. Neuronale Netze tauchten nach 2010 unter dem neuen Namen Deep Learning wieder auf, mit neuen Architekturen, zusätzlichem Schnickschnack und einer Reihe von Erfolgsgeschichten.

In diesem Vortrag erörtert Prof. Trevor Hastie die Grundlagen neuronaler Netze und des Deep Learning und geht dann auf einige der Spezialisierungen für bestimmte Probleme ein, wie z. B. Faltungsneuronale Netze (CNNs) für die Bildklassifizierung und rekurrente neuronale Netze (RNNs) für Zeitreihen und andere Sequenzen.

Zugangsdaten

Zoom-Meeting beitreten

https://leuphana.zoom.us/j/99663552105?pwd=dG9KZUtJU0hUMkE4RHNEVDhiUlNIZz09

Meeting-ID: 99663552105

Kenncode: FoKoWI